近日,北京大學化學與分子工程學院聯(lián)合計算中心、計算機學院、元培學院發(fā)布化學大模型基準SUPERChem。該基準針對當前化學知識水平評測中題目難度有限、多模態(tài)與推理過程評估缺失等不足,系統(tǒng)構建了專注評估大語言模型(LLM)化學推理分析能力的新體系,旨在推動化學智能評測的深入發(fā)展。

2025年,隨著開源推理模型DeepSeek-R1推出,LLM在“深度思考”范式下快速發(fā)展,其在自然科學領域的應用已從簡單問答轉向復雜推理。然而,現(xiàn)有通用科學基準趨于飽和,化學專用基準多關注基礎能力與化學信息學任務,缺乏對深度推理的系統(tǒng)考察。

從基礎教育、化學奧賽到高等教育,化學學習強調知識綜合運用與多步推理,是評估推理分析能力的理想場景。設計高質量評估題目需融合抽象概念與具體情境,構建層層遞進的推理鏈,對出題者專業(yè)素養(yǎng)要求極高。

研究團隊依托北京大學化學與分子工程學院高水平的學生群體,充分發(fā)揮其扎實學科功底與豐富解題命題經(jīng)驗,對已有題目素材進行準確評估與合理優(yōu)化,共同構建了SUPERChem基準,填補了化學深度推理評估的空白。

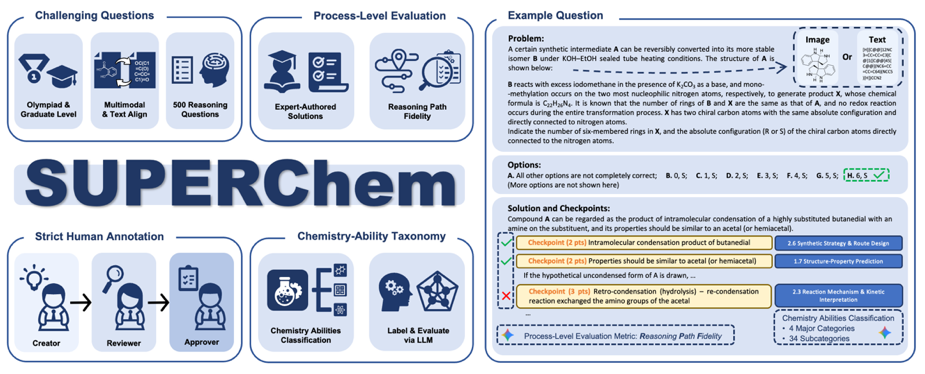

SUPERChem總覽與例題

SUPERChem題庫的三階段審核流程

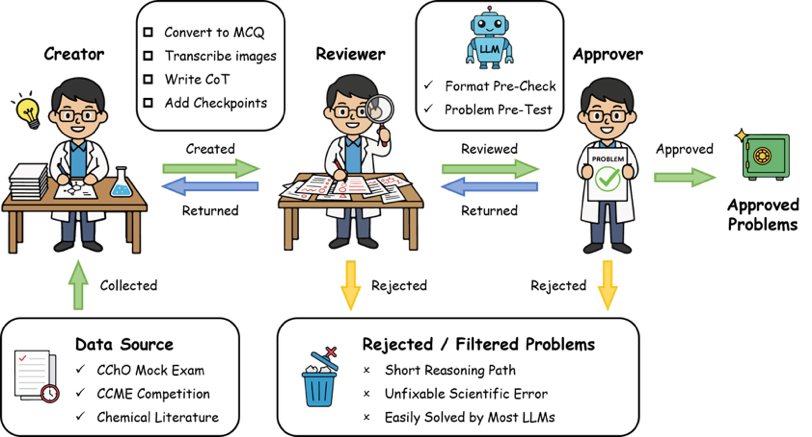

SUPERChem題庫由北大化學專業(yè)近百名師生共建,涵蓋題目編寫、解析撰寫及嚴格評審的三階段審核。題目源自專業(yè)改編,并采用防泄漏設計,避免LLM依賴記憶或從選項逆推。針對化學信息的多模態(tài)特點,同步提供圖文交錯與純文本版本的對齊數(shù)據(jù)集,支持探究視覺信息對推理的影響。

目前,SUPERChem先期發(fā)布500道專家級精選題目,覆蓋結構與性質、化學反應與合成、化學原理與計算、實驗設計與分析等四大化學核心領域。為細粒度評估LLM思考過程,SUPERChem引入推理路徑一致性(Reasoning Path Fidelity,RPF)指標:團隊為每道題目撰寫了含關鍵檢查點的詳細解析,通過自動化評估模型思維鏈與解析的一致性,判別模型是否真正“理解”化學。

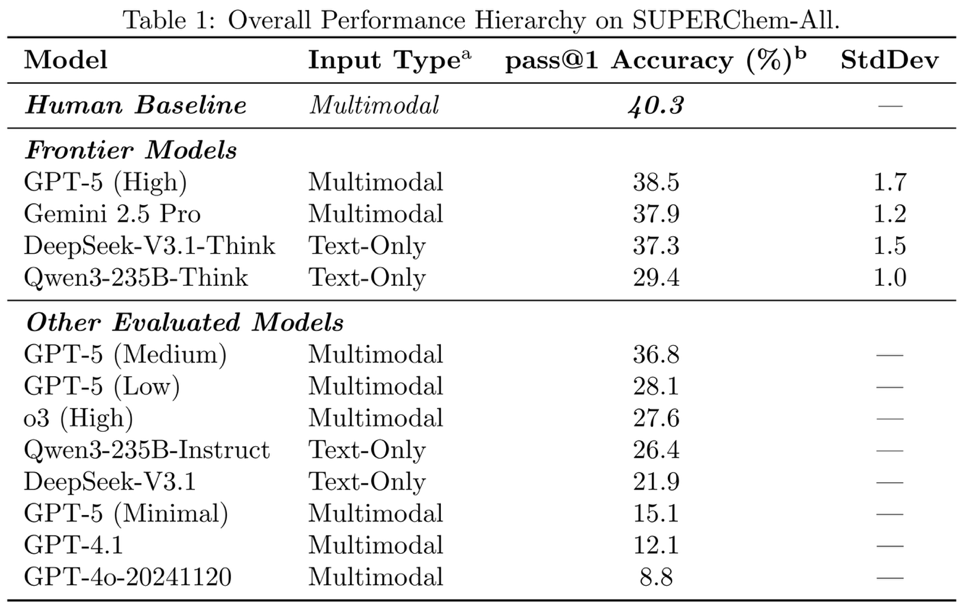

前沿模型在SUPERChem上的表現(xiàn)

評測結果顯示,SUPERChem具有較高難度與區(qū)分度。在化學專業(yè)低年級本科生閉卷測試中,人類準確率為40.3%。參與評測的前沿模型中,表現(xiàn)最佳的GPT-5(High)準確率為38.5%,表明其化學推理能力與低年級本科生水平相當,尚未超越人類基礎專業(yè)認知。

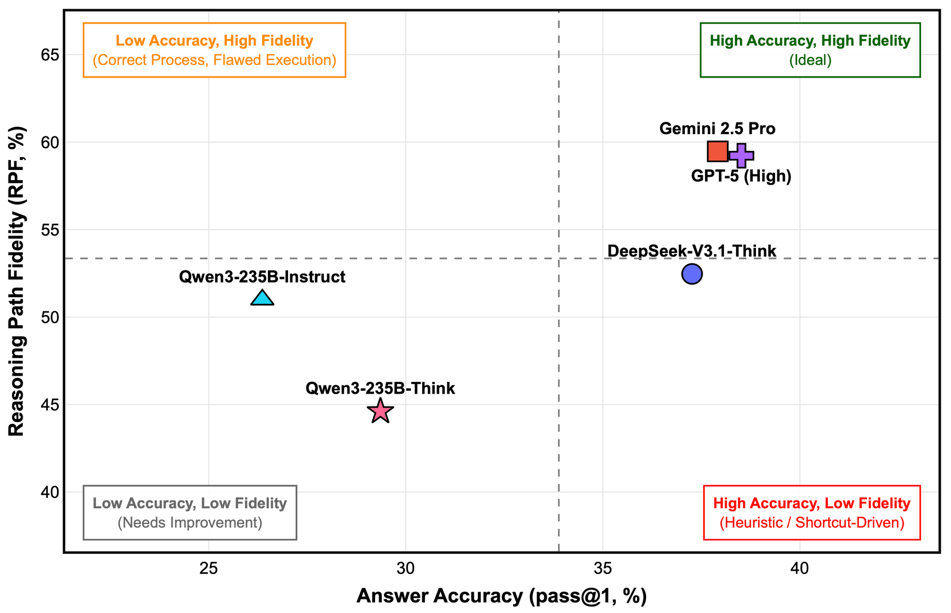

前沿模型的正確率與RPF關系

分析RPF指標可見,不同模型推理過程質量差異明顯:Gemini-2.5-Pro和GPT-5(High)在取得較高準確率的同時,其推理邏輯也更符合專家路徑;而DeepSeek-V3.1-Think雖然準確率相近,但RPF得分相對較低,反映其更傾向通過啟發(fā)式路徑得出結論。

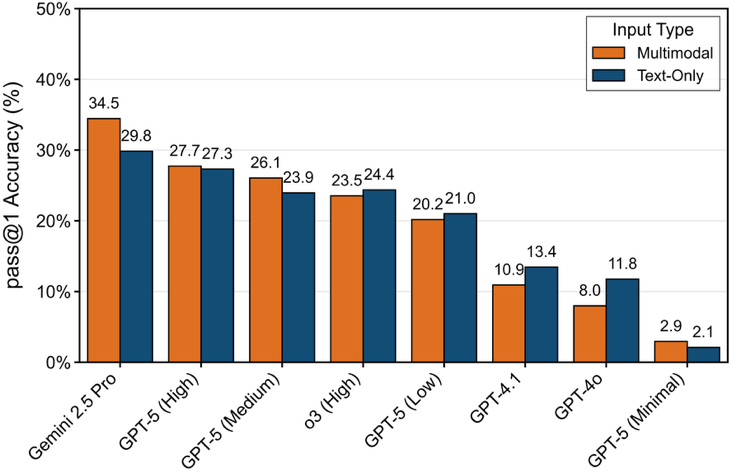

輸入模態(tài)對不同模型的影響

在依賴多模態(tài)輸入的題目中,視覺信息對不同模型影響各異。對Gemini-2.5-Pro等強推理模型,圖像輸入可提升準確率;而對GPT-4o等推理能力較弱的模型,圖像信息會造成干擾。這表明在科學任務中需根據(jù)模型能力匹配合適的輸入模態(tài)。

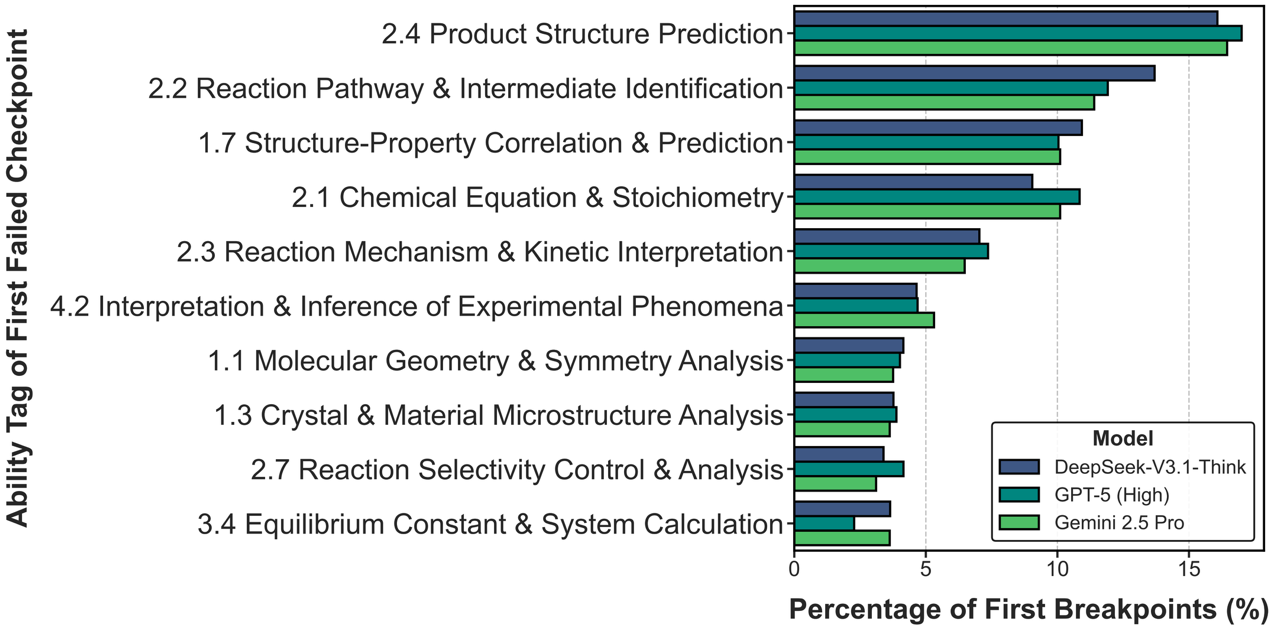

為進一步探究LLM推理失敗的深層原因,研究團隊進行了推理斷點分析。結果表明,前沿模型的推理斷點集中于產(chǎn)物結構預測、反應機理識別、構效關系分析等高階化學推理環(huán)節(jié)。這反映出當前LLM在涉及反應性與分子結構理解的核心任務上仍存在短板。

推理斷點所屬化學能力分布

綜上所述,SUPERChem為系統(tǒng)評估大語言模型的化學推理能力提供了細致、可靠的基準。評測結果指出,當前前沿模型的化學能力仍處于基礎水平,在涉及高階化學推理能力的任務上存在明顯局限,為后續(xù)模型的針對性優(yōu)化提供了明確方向。

SUPERChem項目由北京大學化學與分子工程學院和元培學院的趙澤華、黃志賢、李雋仁、林思宇同學領銜完成。近百位化學與分子工程學院博士生和高年級本科生參與題庫構建與審核,其中包括多位國際與中國化學奧林匹克決賽獲獎選手。174位北京大學化學專業(yè)低年級本科生參與了人類基線測試。

SUPERChem項目在北京大學化學與分子工程學院裴堅、高珍老師,計算中心馬皓老師,計算機學院楊仝老師的指導下開展。項目獲得北京大學計算中心與高性能計算平臺資源支持,來自Chemy、好未來、質心教育等機構和化學與分子工程學院鄒鵬、鄭捷等多位教授的題目素材支持以及高楊、龍汀汀老師的專業(yè)協(xié)助。

信息來源: 北大化學與分子工程學院